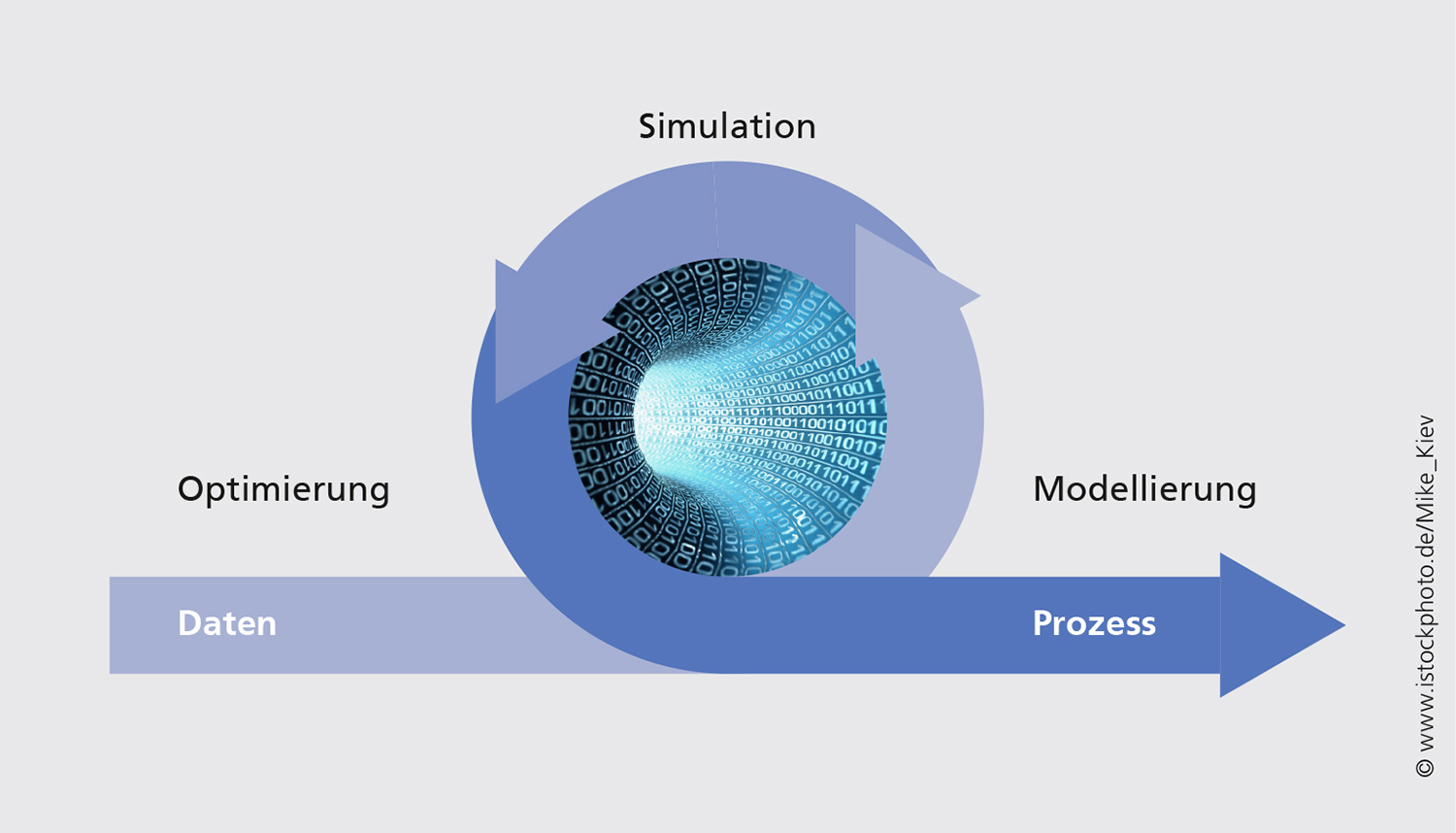

Die Virtualisierung chemischer Produktionsanlagen in einem Modell und die sich daran anschließende modellbasierte Optimierung sind wichtige Schritte zu Innovation sowie Effizienz- und Qualitätssteigerung. In einem bilateralen Kooperationsprojekt entwickeln wir mit der BASF SE Methoden zur hybriden Modellierung, in der physikalisch-chemisches Wissen (»white«) mit datengetriebenen Ansätzen (»black«) in einem Gesamtmodell integriert wird. Diese Methoden werden in einem BASF-eigenen Fließbildsimulator integriert, so dass sie den Prozessingenieuren dort für ihre tägliche Arbeit zur Verfügung stehen.

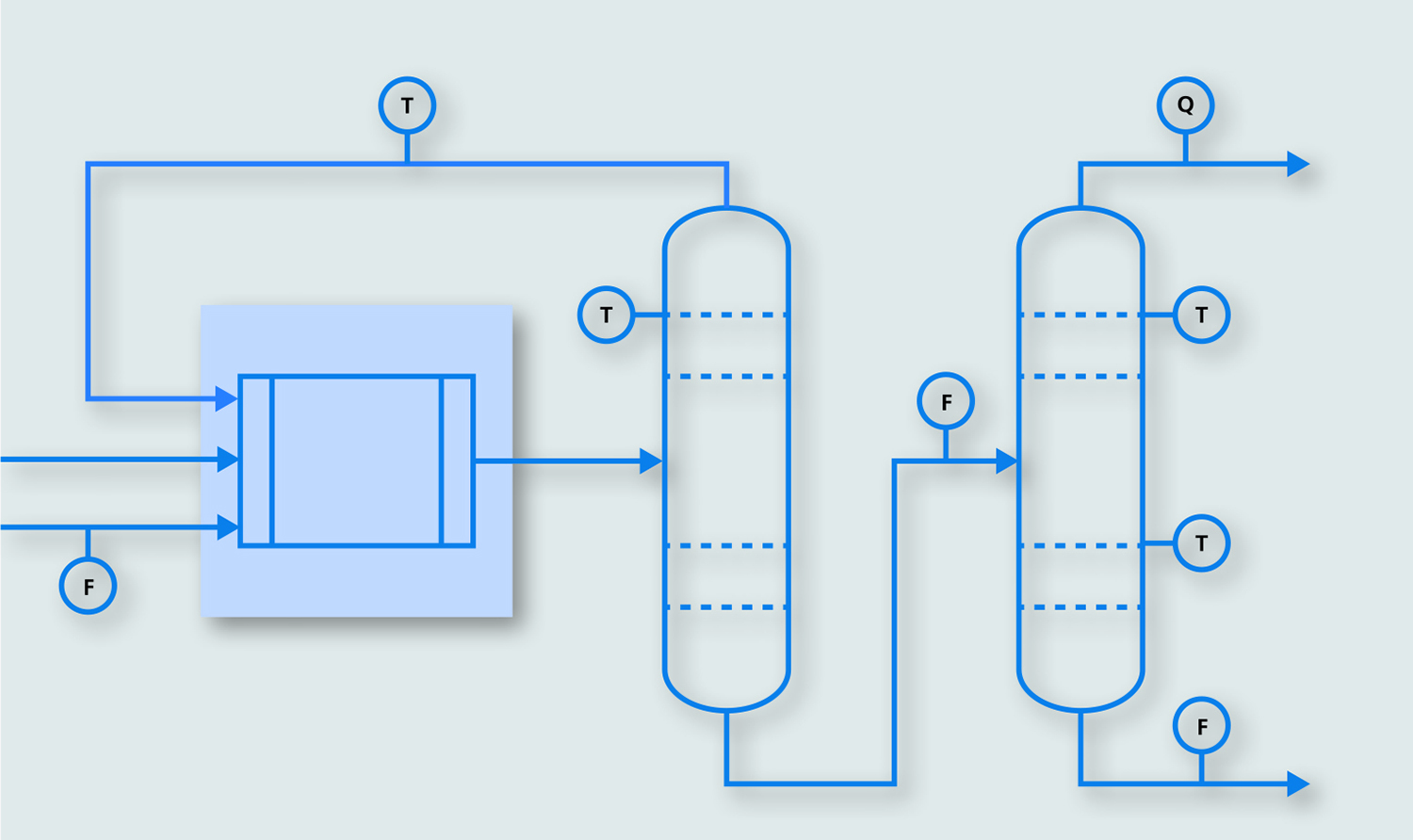

Ein typischer chemischer Produktionsprozess enthält einen chemischen Reaktor zur Stoffumwandlung. Die Edukte des Reaktors werden einer Aufreinigung zugeführt, die beispielsweise destillativ erfolgen kann. Soll dieser Prozess in einem Fließbildsimulator modelliert werden, sind einerseits Kenntnisse über die chemischen Reaktionen nötig, andererseits muss die Thermodynamik der Auftrennung bekannt sein.

In der industriellen Praxis typisch ist die Situation unvollständig bekannter Stöchiometrien und Reaktionskonstanten, wohingegen die destillativen Prozesse eher bekannt sind. Neben diesem physikalischen White-Box-Wissen liegen historische Prozessdaten von verschiedenen Messstellen vor. Hier ist bewusst ein Fall dargestellt, wo die Eingänge des zu modellierenden Apparats ungemessen sind.

Erster Schritt: Short-Cut-Modell

Die Aufgabe des Projekts besteht darin, Informationen aus den Prozessdaten zu generieren, mit denen die Lücken des physikalischen Modells geschlossen werden können. Dazu wird in einem ersten Schritt der Reaktor durch ein vereinfachtes Short-Cut-Modell ersetzt, das – zusammen mit dem Modell der Aufreinigung – alle vorhandenen physikalischen Gleichungen enthält.